La donnée… Derrière ce terme vague cachant un ensemble de mesures ou d’observations, certains y verront à raison un outil à l’impact environnemental lourd, qui peut siloter, restreindre, effacer le réel. Mais la donnée est aussi un outil puissant pour qualifier, comprendre, transformer, aménager nos territoires à la compréhension de leurs réalités et leurs besoins ; un outil innovant pour créer de nouveaux usages par le croisement, l’interconnaissance et la recherche.

La DatAgora, dont le tout nouveau site de présentation est à retrouver ici : https://www.datagora.erasme.org/, s’inscrit dans cette valorisation de la donnée d’intérêt général, en mettant à disposition des acteurs locaux les données, les outils et les méthodes pour mener à bien leurs projets basés sur cette donnée. Ce projet porté par l’université de Lyon, le service Données Métropolitaines et Erasme est en expérimentation depuis 2020 et a déjà produit de nombreux dispositifs innovants mobilisant la donnée. La DatAgora a été sélectionnée pour recevoir un soutien de France Relance, et lance dans le même temps un vaste appel à manifestation d’intérêt pour recueillir les sujets de développement et de prospective liés à l’usage de la donnée publique ! Chacun peut y candidater et découvrir toutes les informations de l’AMI (appel à manifestation d’intérêt) à travers ce lien : https://form.typeform.com/to/O9yePTtx.

A l’initiative de cette démarche, ses trois porteurs vont chacun nous partager leur vision personnelle de la donnée et de ses actions sur le territoire. Pour ce premier entretien, partons à la rencontre de Patrick Vincent, directeur de projets à Erasme.

Bonjour Patrick. On commence fort, peux-tu te présenter avec une surprise provoquée par une visualisation de données percutante ?

Bonjour Anthony ! Mon expérience -ancienne- dans les domaines de la muséographie et de la communication publique m’a effectivement appris que la donnée possède un pouvoir de médiation très puissant lorsqu’elle est utilisée au croisement de ces deux champs : la mise en récit et l’objectivation. C’est à dire comment raconter une réalité scientifique ou historique de manière parlante et engageante pour chacun d’entre nous !

Deux exemples marquants me viennent à l’esprit :

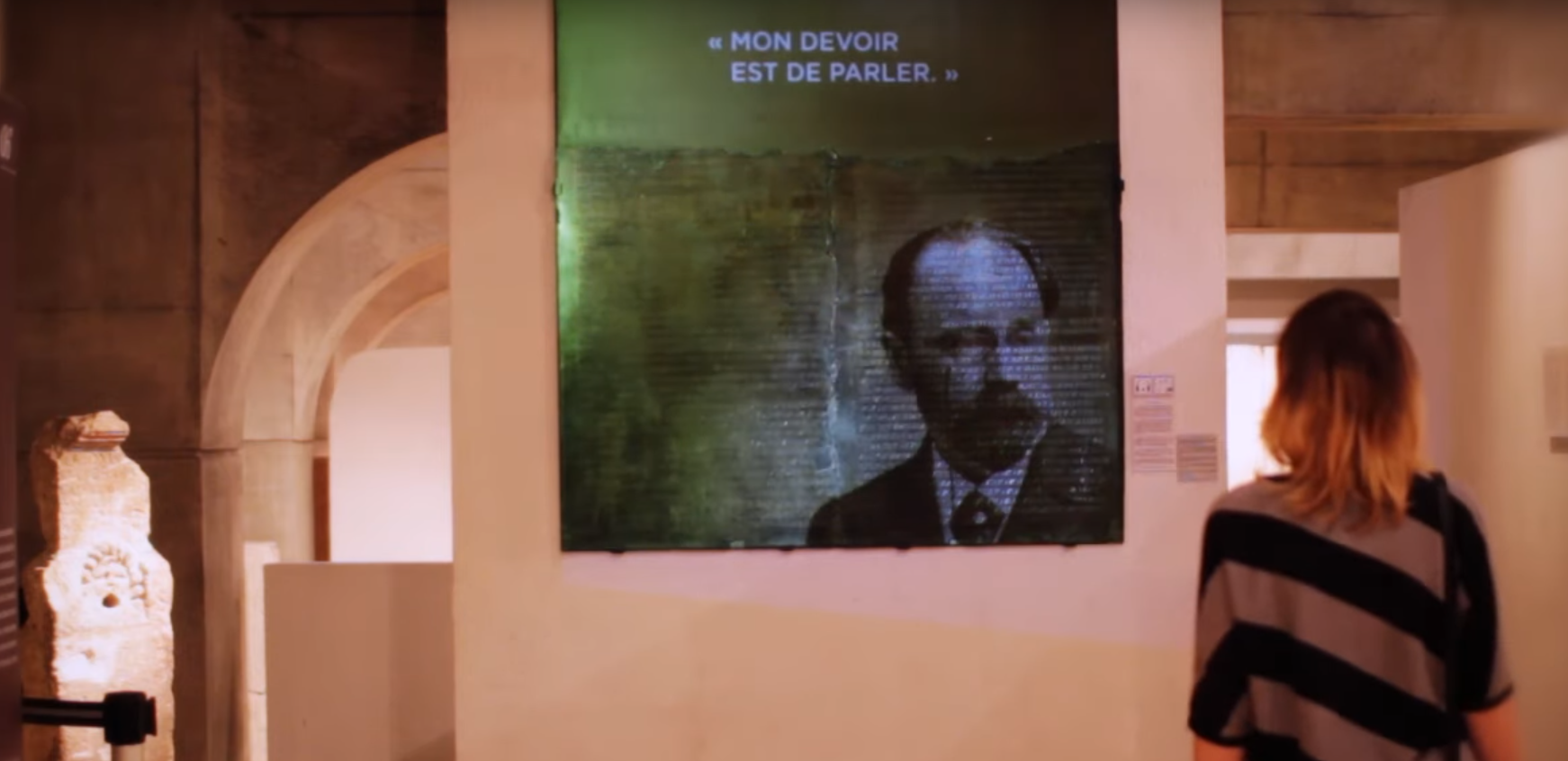

Le premier concerne l’augmentation de la table claudienne [1] du musée gallo-romain Lugdunum réalisée pendant l’évènement Museomix de 2012. Cette table en bronze est une pièce imposante et majeure du parcours de visite, dont l’inscription gravée en latin restitue une partie du discours de l’empereur Claude. Sans explications, on ne saisit pas la portée politique de ce texte, qui élève en réalité les droits des gaulois et étrangers de la cité au rang de citoyens romains (pouvant même accéder à la fonction de sénateur)… et ce en 48 après JC ! Le dispositif d’augmentation a ainsi ajouté une projection visuelle puis sonore de portraits historiques célèbres avec leurs propres propos d’intégration politique (Martin Luther King, Voltaire, etc) diffusés au fur et à mesure que le visiteur s’en rapproche… pour finir par Claude lui-même !

En procédant par analogies proches et documentées, la médiation d’une donnée historique complexe et éloignée, se révèle finalement d’une réalité très contemporaine et d’une continuité malheureuse de l’histoire de la discrimination et l’intégration.

On pourrait citer dans le même esprit les maquette augmentée du château des ducs de Bretagne à Nantes, Le Vase Qui Parle à Lille ou la roue des inventions du musée des confluences qui toutes mobilisent l’expérience tangible au service de la compréhension.

En ligne, je pense aux productions de datastorytelling de la cellule Interactive du New-York Times, à l’instar des animations didactiques et saisissantes sur les sujets d’actualité ou les travaux entrepris par l’émission DataGueule .

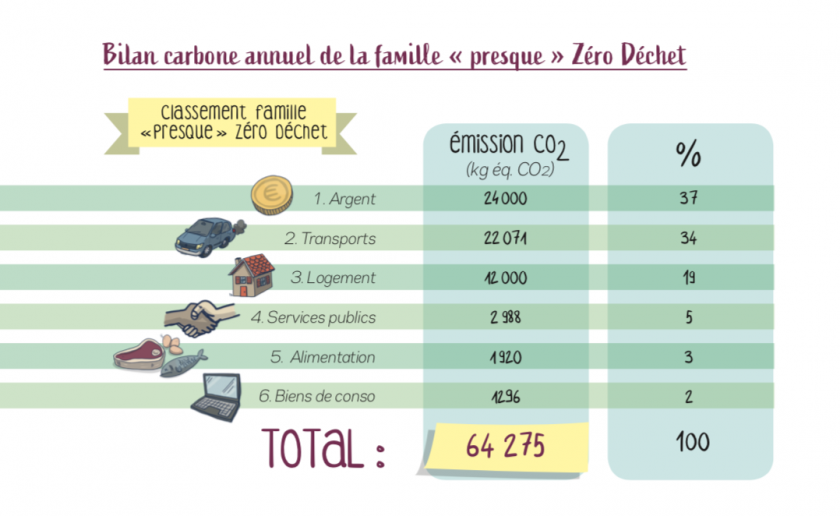

Le second est une expérience beaucoup plus minimaliste qui remonte à 2017 : à la lecture d’un livre familial sur la transition écologique, un rapport du cabinet Utopies classe dans une infographie comparative l’impact écologique des activités d’une famille française sur l’environnement pour conclure que « 40 % de l’impact carbone d’un individu est généré par son argent et donc le choix de sa banque. C’est le premier facteur sur lequel il faut travailler pour opérer la transition écologique ». Contrairement à toutes les idées reçues à l’époque un sujet très peu visible arrive donc sur le devant de la scène, par une représentation simplifiée comparative et peut déclencher des prises de conscience ou des passages à l’action. On peut citer dans les même esprits les représentations simplifiées mettant en visibilité les phénomènes exponentiels de manière pédagogique, comme l’accélération des modes de communication, par D.De Kerckhove, l’explosion de l’usage du smartphone sous le prisme de la photographie, ou les plus anciennes équations du nénuphar d’albert jacquart...

Source : Famille en transition, Jérémie Pichon, Bénédicte Moret

On comprends aisément que ce pouvoir de la médiation - voire de la subversion - d’une donnée qui "révèle l’invisible" par la narration doit être conditionné à la diffusion d’un étayage scientifique rigoureux à même d’accompagner chacun d’entre nous dans un parcours d’apprentissage ou d’expérience de la complexité : sensibilisation à un sujet inconnu, acquisition de savoirs plus rigoureux et complets, multiplication des sources et des expériences, aide à la décision, acquisition de savoirs-faire, passage à l’action...

C’est la rupture même de cet équilibre (de narration et de rationalité) qui a nourri le terreau des courants récents de fake news ou d’algorithmes viraux de réseaux sociaux plus centrés sur le design émotionnel que sur la rigueur de faits complexes vulgarisés. Une démarche de data storytelling nécessite plus que jamais l’existence et la mise en avant de “tiers de confiance” de la donnée et de sa valorisation que sont les laboratoires de recherches scientifiques, les acteurs et collectivités publiques et les journalistes de la donnée.

Il y a eu beaucoup d’attentes vis à vis de la "smart city” ou des jumeaux numériques, ces paradigmes sont-ils toujours d’actualité ou ont-ils été remplacés par de nouveaux, peut être plus low tech ?

Ah… la smartcity. Né dans les années 2000, le concept des smartcities a été d’autant plus difficile à construire et à démocratiser en tant que principe de développement qu’il fut utilisé comme marqueur de compétitivité des villes, et donc rapidement fourre-tout (quantité et qualité d’infrastructures, réseaux, transports, de données puis de capitaux sociaux, environnementaux et enfin de modalités de gouvernances collaboratives de l’innovation) accélérant son abandon au bénéfice de concepts plus clairs comme ceux de la transition, de l’inclusion ou de la résilience socio-économique et écologique des territoires.

En réalité la smartcity propose une approche méthodologique intéressante en terme d’interopérabilité (ou plateformisation) des services, de pluralité et réciprocité du lien entre les acteurs, mais aussi d’évaluation, de transparence et de responsabilité en vue de l’adaptabilité des systèmes, après avoir bien sur dépassé le malentendu de sa proposition historique très techno-push... [2]

On pourrait donc retenir que les transformations majeures qui s’opèrent aujourd’hui sur le territoire sont héritières de la “smartcity” et portées principalement sur le développement de nouveaux usages ou de nouveaux systèmes [3] au croisement :

- d’aspiration sociales/individuelles profondes portées sur des communs / projets collectifs

- d’une capacité de production et d’innovation rapide, réelle et proche du terrain.

- de gouvernances ouvertes, capables de partager une vision, d’anticiper et de s’adapter, notamment en période de crise

La Cité des Halles : une démarche d’urbanisme transitoire à Lyon pour répondre de manière innovante à des enjeux sociétaux. Illustration réalisée par Simon Bailly / Kiblind Agence – Source : UrbanEra

Côté data, ce sont bien des besoins et des enjeux similaires qui animent notre travail :

- un hub (réservoir) de données de référence, à la fois reconnu pour sa neutralité et par ailleurs fortement interopérable. C’est le rôle joué par la plateforme data.grandlyon.com. Elle sanctuarise par son expertise des contenus qualifiés et les communs de la donnée, forme, initie aux bonnes pratiques la concernant.

- des démarches de mise à jour (crowdsourcing [4]) et de multiplication des utilisations qui par leur pluralité garantissent la qualité et la maintenance répartie de la donnée. Une transparence sur l’historique des données, les discussions le cas échéant ainsi que les licenses d’usages garantit leur “démocratie” et leur légitimité de la donnée, à l’instar des espaces “backoffice” des articles de Wikipedia.

- une démarche de laboratoire de conception de nouveaux usages ouverte, visant à utiliser la donnée comme levier de compréhension ou d’exploration de modes de vivre ensemble renouvelés (aide à la décision, co-construction, vulgarisation de sujets complexes, …)

C’est précisément pour se mettre au service de projets ou d’usages impactant positivement le territoire que doivent être maîtrisés des outils innovants (maquette augmentée, réalité virtuelle/metaverse…), des types de données avancées (cartographie du bien être, jumeau numérique ...) ou méthodologies poussées (analyse profonde de la donnée, infovisualisation...), mais uniquement comme moyen, selon des hypothèses à vérifier, d’accompagner ces transformations et ce changement (et non l’inverse comme le suggérait la vision technique de la smartcity).

On peut citer le cas intéressant de la concertation citoyenne participative, défrichée par le projet Unicité [5] autour de la réalité virtuelle en 2016 et aujourd’hui généralisé par des immersions 3D pour faciliter la projection, les suggestions d’usages et les arbitrages dans les aménagements urbains comme le projet du projet Oullins : Quelle ambiance pour la future place Anatole France [6] ?

Projection dans un futur possible de la place Anatole France

Dans d’autres cas la donnée sera valorisée par de simples impressions, comme dans le cas du projet Interpretable [7] qui vient proposer aux personnels soignants des planches velledas de pictogrammes pour accompagner la communication non verbale avec les patients allophones ou réfugiés.

En conclusion c’est plus d’une culture des possibles techniques et d’une boite à outil méthodologique dont a besoin la culture publique de la donnée et la créativité collective (datalitteracy) que d’un système pré-fléchant/induisant les technologies et formes de réponse à des problématiques encore inconnues, comme la systématisation de l’usage d’un jumeau numérique en réalité virtuelle par exemple.

La sédimentation vers des pratiques normées intervient finalement toujours de manière plus naturelle que la recherche de solutions créatives et ouvertes !

La Datagora offre une nouvelle façon d’aborder la donnée, croisant des problématiques très concrètes du terrain à des sujets de recherche avancée. Après plus d’un an d’expérimentation, que permet une telle organisation ?

Comme nous l’évoquions juste avant, la maîtrise seule d’une donnée de qualité ne suffit pas et n’est pas soutenable pour le cadre public seul, si elle n’est pas accompagnée d’une démarche de recherche et de développement d’usages divers, co-construits et appropriés.

La Datagora joue ainsi le rôle de DataLab incarné des usages de la donnée publique sur le territoire grand lyonnais :

- produire des visualisations avancées et des représentations donnant du sens à la donnée (voire à la masse de données) et support à la prise de décision publique

- produire des nouveaux services et outils d’intérêt généraux

- de manière induite, démocratiser l’usage de la donnée publique et fédérer une communauté d’acteurs de référence sur la veille, la prospective et la recherche

Au cours de sa première année, la Datagora a conduit plusieurs projets pilotes et produit un cadre méthodologique ainsi qu’une offre de service à la fois tournée vers l’expérimentation mais aussi la documentation/réplicabilité :

- DataXP : des dispositifs interactifs, algorithmes, nouvelles données à haute valeur ajoutée développés en partenariat et débouchant sur des expérimentations publiques (végétalisation, mobilité, industrie, maintenance prédictive, self data....)

- DataValo : des visualisations, analyses représentations de la donnée ou de nouvelles données créées par croisement en moins d’une journée de travail (indicateur de trafic, diagnostic social d’un territoire...)

- Datanimation : un format d’animation ou de médiation à même d’acculturer un public visé autour de la donnée ou par la donnée

- Datacomposant : des plateformes ou kits permettant de répliquer n’importe laquelle de ces démarches

- Datacommunauté : des rencontres pour faire émerger de nouvelles opportunités autour de la donnée !

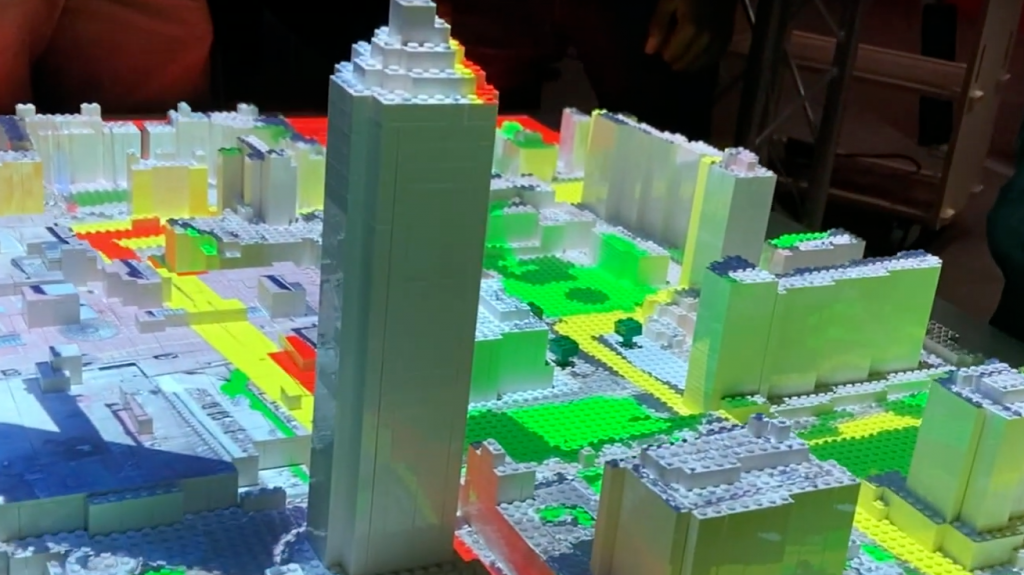

Un dispositif interactif produit par la DatAgora : la maquette augmentée

Le fil conducteur de cette première année a donc été la mutualisation d’objectifs et de compétences publiques entre les trois porteurs : l’université de Lyon, et deux services de la métropole : Erasme et le service données métropolitaines. Cette mutualisation, répartie dans différents lieux et sur différents sujets, donnera corps en 2022 à un outillage avancé et un lieu dédié au sein du futur urbanlab d’Erasme, documenté pour sa possible reproduction.

Des exemples concrets pour illustrer ce qu’a produit ou va produire la DatAgora ?

En 2021 ce sont surtout des expérimentations publiques internes à la métropole de Lyon qui ont été conduites :

- un indicateur de trafic automobile sur l’ensemble du territoire conçu en 1 journée

- une maquette interactive territoriale tangible de concertation pour la végétalisation participative du territoire

- une cartographie Web pour la mise en valeur de structures et d’événements de médiation industrielle

- un sujet de maintenance prédictive des canalisations publiques

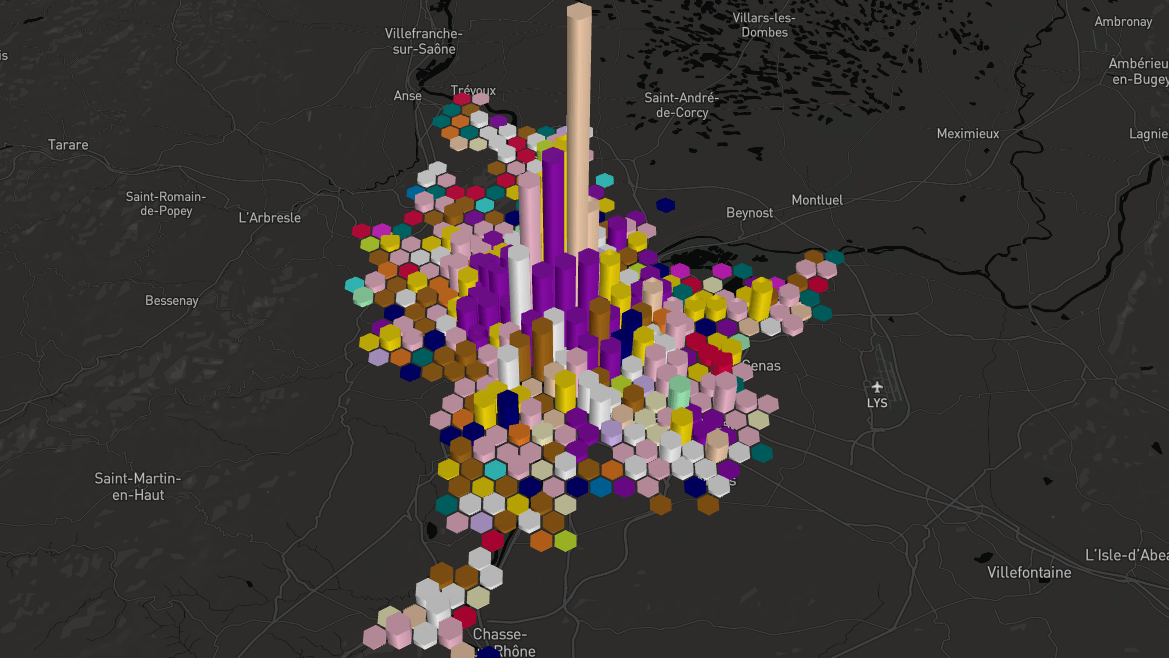

Mise en visibilité des sièges d’entreprises sur la métropole : http://dataviz3dindustries.datagora.erasme.org/

Ces sujets permettent d’envisager de nouveaux projets :

- la réalisation d’un calque de plantabilité territorial : visant à identifier la faisabilité de plantation échelonnée (3 valeurs à minima). Cet outil bénéficiera à la fois d’un calcul global sur le territoire au regard des informations connues et d’une amélioration progressive, à chaque fois qu’une zone sera concernée par des études ou travaux approfondis

- la production d’un outil de cartographie interactif nommé Datatlas permettant de créer à la volée des représentations cartographiques croisant plusieurs jeux de données et simplifiant l’animation de la relation usager par le crowsourcing et les modes de visualisation avancées. Plusieurs sujets tels que l’opendata de l’alimentation locale et responsable, ainsi que la cartographie de la végétalisation participative sont concernés par cet outil.

Mais les autres projets ne sont pas encore identifiés et doivent maintenant se connecter à une pluralité d’acteurs plus large, là où la Datagora est finalement là pour agir sur la réel et expérimenter de nouveaux modes de vie.

Si l’on parle par exemple de modélisation du métabolisme urbain en vue de réorganiser l’économie circulaire du quartier ou sa logistique du dernier kilomètre, de la décroissance de l’achat neuf par l’utilisation d’infovisualisations percutantes sur ses impacts écologiques ou bien encore la mise en lumière du rôle des influenceurs rémunérés ou bots en ligne dans les mécaniques de développement psychologique des adolescents, basée sur la comparaison et la performance individuelle... la datagora doit être présente !

Pour ce faire nous lançons un appel à manifestation d’intérêt pour recueillir les sujets de développement et de prospective liés à l’usage de la donnée publique. Pour cela chacun peut candidater et ainsi se rapprocher d’un interlocuteur métier de la métropole lié à la thématique. Il sera important de confirmer l’engagement des candidats pour suivre avec l’équipe de la métropole le projet soumis, car une expérimentation ne réussit que si elle est coportée et pilotée par tous les bénéficiaires.

Nous en profitons pour partager le site de la démarche : https://www.datagora.erasme.org/ et le présent AMI : https://form.typeform.com/to/O9yePTtx soutenus par plusieurs dispositifs Plan de relance depuis l’été 2021 !

Le mot de la fin ?

Les perspectives nombreuses ouvertes par la valorisation de la donnée d’intérêt générale nous motivent tant par leur possibilité d’impact rapide que leur rôle charnière, à l’interface de toutes les acteurs publics, au moment où les défis économiques, sociaux et environnementaux qui occupent notre territoire et notre quotidien dépassent justement tous les cloisonnements existants.